IL RISCHIO ESPLOSIVO IN GALVANICA

Nel settore trattamenti la frequenza del rischio di esplosione è fortunatamente bassa. Quello che preoccupa, però, è la magnitudo del rischio, ed è per questo che è doveroso affrontare il problema.

Nelle nostre galvaniche prevalentemente zincature, nichelature e cromature non ci dovrebbero essere grossi problemi di rischio da esplosione. In effetti nella mia frequentazione oramai sessantennale delle officine galvaniche gli unici botti frequenti che ricordo e che mi impressionavano da bambino erano quelli provocati ad arte dall’operatore galvanico per “schiumare” la sgrassatura.

Il rischio di esplosione da polveri

Non mi permetto valutazioni sul settore dell’alluminio, la sola presenza di tale materiale e quindi la possibilità che sia presente in polvere (con alta facilità di incendio ed esplosione) imporrà certo cautele specifiche. Nel mio corso “approccio globale alla valutazione del rischio” mi permetto di citare il fatto che nell’area Verbania-Cusio-Ossola, dove si producevano circa 60.000 caffettiere di alluminio al giorno ed una conseguente produzione stimata giornaliera di 540 Kg di polveri d’alluminio, si sono verificati nel periodo 1990-2001 sei incidenti esplosivi con 2 morti e 16 feriti. Al riguardo rimando gli interessati al non recente, ma ancora ben utile, opuscolo edito nel maggio 2001 sotto l’egida della Regione Piemonte: “Esplosioni da polveri nei processi di finitura di manufatti in alluminio e leghe nella realtà produttiva ASL 14 VCO: analisi del rischio e misure di prevenzione”, pubblicazione a cura del dipartimento Prevenzione dello Spresal e di CNR FIRGET. Nel suo prologo il Dott. Mario Valpreda diceva: “Le polveri di alluminio che si liberano durante le operazioni di pulitura dei metalli possono causare esplosioni. Sembra un’evenienza rara, ma l’esperienza dimostra che l’area del rischio è ampia”.

L’area dei trattamenti superficiali e molto ampia, non si smette mai di imparare cose nuove in questo settore fatto sì di terzisti “generalisti” ma anche di tante nicchie ultraspecializzate. È impossibile quindi conoscere tutto quello che avviene in queste molteplici e spesso piccole o addirittura microaziende. Quello che mi preme qui ricordare è che le polveri in generale possono comportare il rischio di esplosione e per sottolineare quanto questo sia vero cito tra i casi casi un’altra storica esplosione descritta dal perito incaricato dalla Reale Accademia delle Scienze di Torino nel 1785, il conte Carlo Ludovico Morozzo di Bianzè, esplosione avvenuta in un modesto panificio!

Il primo assunto, quindi, è che qualsiasi materiale solido in forma pulverulenta che sia in grado di bruciare in aria può causare un’esplosione di intensità tanto più violenta quanto più sottile sia la sua granulometria.

Il secondo assunto da tener ben presente è quello che ci dice come le polveri combustibili depositatesi in strati possono causare un incendio che può degenerare in esplosione quando lo strato si disperde in aria creando una nube.

Le polveri possono così dar luogo a 2 fenomeni:

– esplosione primaria;

– esplosioni secondarie: le polveri sollevatesi dall’esplosione primaria causano a loro

volta una reazione esplosiva

Ne consegue che ognuno nella sua officina deve valutare il pericolo di accumulo e stratificazione di polveri e provvedere con mezzi idonei alla loro rimozione in sicurezza. Se poi le polveri sono destinate ad impianti di captazione è bene che questi incorporino le dotazioni necessarie a evitare detonazioni o deflagrazioni che debbono essere certificate e munite dell’apposito marchio europeo.

Il rischio da esplosioni “chimiche”

Riprendendo quanto detto a proposito delle nostre galvaniche, in generale non dovrebbero essere presenti sostanze che espongono al rischio di formazione di miscele esplosive. Il galvanico è l’ultimo della sua filiera, spesso si trova ad affrontare i problemi causati da tutti coloro che l’hanno preceduto nella manifattura dell’oggetto che lui è chiamato a rifinire per renderlo vendibile. Se è stato usato un olio o della pasta abrasiva di scarsa qualità, se il saldatore ha spruzzato un prodotto che vetrifica o se la saldatura è stata eseguita in modo particolarmente creativo, se il materiale è sbagliato… il galvanico si ritrova la patata bollente tra le mani. Non di rado capita che il suo consulente chimico suggerisca di risolvere il problema introducendo qualche acido particolarmente forte o qualche nuovo “prodottino”.

Normalmente ciò avviene per quantità modeste ma abbiamo visto cosa succede al nostro Bobby con soli 130 galloni, anche andassimo a 13, in scala 10 a 1, non si dovrebbe comunque scherzare. Quindi fare particolare attenzione alle nuove sostanze introdotte anche solo sperimentalmente, analizzare bene la scheda di sicurezza, verificarne la volatilità e considerare la presenza di sostanze che ora andiamo ad elencare. In particolare, evitare di formare miscele contenenti NH3, O2 e NOx che possono dar luogo a formazione di nitrato d’ammonio che è esplosivo.

Anche i perossidi possono reagire violentemente, vi è un caso segnalato nel registro europeo degli incidenti rilevanti e-MARS accaduto nel reparto depurazioni di una galvanica, in questo caso la reazione non ha dato luogo ad una esplosione ma poco ci mancava. La stabilità termodinamica delle sostanze dipende dalla loro composizione e, più precisamente, dalla presenza nella loro molecola di taluni “gruppi funzionali”. Le “sostanze termodinamicamente instabili” sono ben descritte nell’apposito quaderno reperibile sul sito dell’Inail e sono:

derivati dell’acetilene

– azo-composti

– perossidi

– ozonuri

– triazeni

– epossidi

– nitroalcani

– nitroso composti

– nitrati di composti ossidrilici (per esempio TNT)

– fulminati

– nitriti organici

– sali di idrossilammonio

– perclorati organici

– cloriti, clorati

La reazione chimica tra acido fluoborico (o altri acidi forti) e metalli comporta la formazione di idrogeno gassoso che è infiammabile ed esplosivo. Nell’e-MARS abbiamo un caso in galvanica di violenta reazione con sviluppo di gas tra acido nitrico e ferro. In tal senso l’acido nitrico è una brutta bestia con molti metalli (zinco, ferro, rame, magnesio) tranne l’alluminio. Anche per questa segnalazione non vi è stata fortunatamente esplosione, ma molti operai sono stati messi sotto osservazione dopo essere stati esposti alle esalazioni. L’acido nitrico è anche in grado di reagire violentemente con sostanze chimiche organiche causando pericolo di incendi e esplosioni.

Ricordiamo poi la regola fondamentale ”mai dare da bere agli acidi” l’aggiunta di acqua può accelerare reazioni ad esempio tra acido solforico concentrato con ferro, alluminio e magnesio.

Per lo zinco in polvere la reazione è diretta. Oltre alla sostanza anche la forma è importante: se aumenta la superficie di scambio (polveri metalliche invece di metallo massivo) anche la reazione sarà più violenta. La stessa reazione accade fra basi forti (sodio idrossido o idrossido di ammonio) e metalli.

Il rischio da esplosioni “fisiche”

Le esplosioni fisiche si verificano quando quantità rilevanti di liquido vaporizzano istantaneamente per ebollizione, con un grande aumento di volume.

Ricordiamo il fenomeno dei BLEVE, Boiling Liquid Expanding Vapour Explosion. Esempi significativi di BLEVE si possono avere a seguito della brusca rottura di recipienti contenenti, per esempio, GPL, metano, etilene, propano, ammoniaca, cloro, anidride solforosa mantenuti liquefatti sotto pressione, oppure liquefatti e mantenuti a pressione atmosferica a bassa temperatura, per esempio ossigeno o azoto liquido. La rottura di bombole può causare una esplosione fisica, con proiezione a distanza di frammenti.

Da evitarsi il versamento in acqua di metallo fuso come alluminio o ferro. Il vapore si sviluppa con grande rapidità, proiettando liquido e generando onde d’urto, pericolose anche a notevole distanza. Anche qui si può approfondire consultando l’allegato presente nello stesso sito dell’Inail dove potete vedere citati anche altri fenomeni quali il “Boil Over” e la “decomposizione esplosiva” di determinati materiali.

La zona di ricarica delle batterie

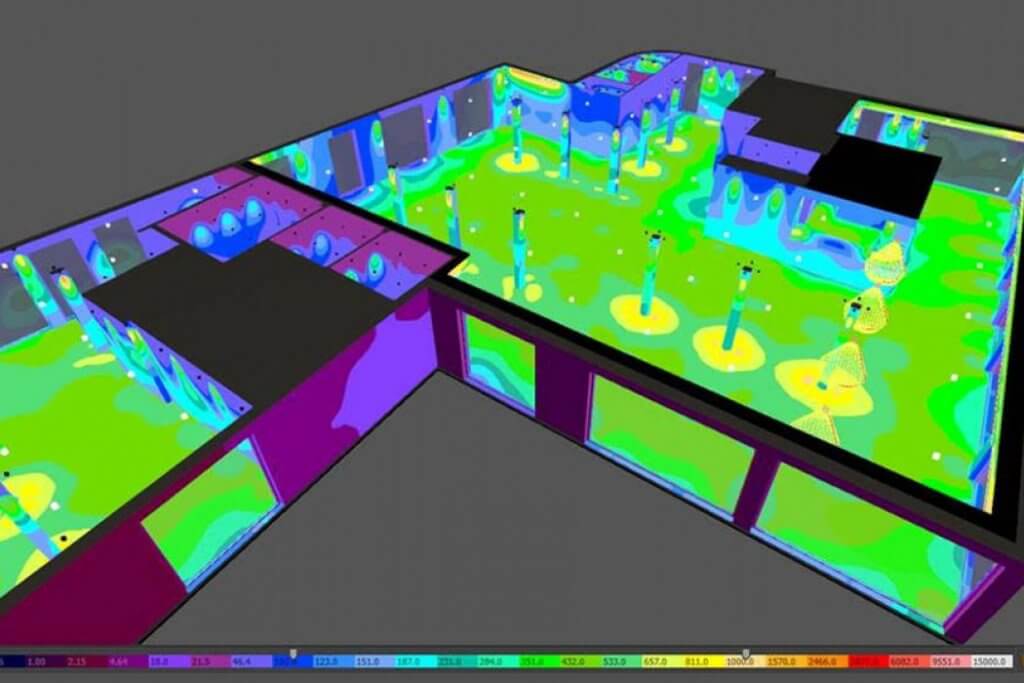

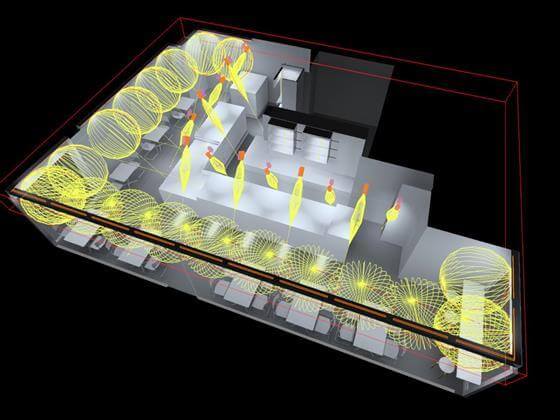

Vale la pena ricordare una delle zone a rischio di esplosione che è presente abbastanza ubiquitariamente nei diversi settori produttivi: la zona di ricarica delle batterie dei carrelli elevatori, dei semoventi elettrici e/o di accumulatori. Credo che anche questo fenomeno esplosivo non sia poi così frequente visto che le moderne apparecchiature di ricarica dovrebbero essere munite di dispositivi di sicurezza che “staccano” al raggiungimento della carica ottimale. In effetti l’elettrolisi dell’acqua della batteria porta ad emissioni di idrogeno, se questo raggiunge la percentuale del 4 % si ottiene una atmosfera potenzialmente esplosiva. La massima emissione di idrogeno avviene quando la batteria è completamente carica, in questa situazione l’energia che forniamo viene tutta utilizzata in elettrolisi. Quindi evitare di porre sotto carica quando non c’è la necessità è un primo ovvio consiglio. Assicurarsi che il caricabatterie interrompa l’alimentazione al raggiungimento dell’obbiettivo è altrettanto ovvio. Quello che si deve attuare in prevenzione è posizionare tale zona in una parte coperta ma ben ventilata evitando così l’accumulo di gas che porti alla formazione di una atmosfera esplosiva. Una buona ventilazione naturale assicurerà una grande riduzione del rischio. Se ciò non fosse possibile si dovrà intervenire con un buon sistema di ventilazione forzata nell’area.

articolo originale

di Lorenzo Dalla Torre tratto da meccanicanews.com